En esta guía te lo voy a explicar todo acerca de LLaMA, el modelo de inteligencia artificial generativa de Meta. También te explico cómo funciona, qué pasos seguir para probar sus capacidades y cuáles son las aplicaciones que ya se están beneficiando de esta tecnología (una pista: Meta AI en WhatsApp). Sin duda, con competidores como tan populares como ChatGPT, podemos decir que LLaMA es una de esas inteligencias artificiales que no conoce tanta gente. Sin embargo, tal y como hicimos con Perplexity AI, aquí te propongo analizar en profundidad esta propuesta y conocer a fondo los detalles más relevantes.

Qué es LLaMA de Meta y cómo funciona

LLaMA es un modelo de inteligencia artificial generativa que funciona de manera muy similar a como lo hace GPT de OpenAI. Se trata de una opción alternativa para crear aplicaciones del estilo de ChatGPT. El desarrollador de LLaMA es Meta, la misma empresa que está detrás de WhatsApp, Facebook e Instagram.

Algo en lo que destaca LLaMA es que ha sido lanzado como modelo open source, es decir, de código abierto. Esto lo aleja muchísimo de los modelos comerciales de empresas como Google, Gemini Ultra, Flash y Nano, y OpenAI, GPT-4o y 4o mini. ¿Por qué? Por la sencilla razón de que cualquiera con los conocimientos necesarios, va a poder modificar el modelo y ajustarlo a sus necesidades.

Además, que este sea un proyecto de código abierto hace que sea gratuito para cualquier usuario o empresa. Como consecuencia, LLaMA se puede implementar en distintos entornos, ser afinado para necesidades específicas y usarse sin pagar por tokens o llamadas a una API. Incluso es posible aprovechar sus capacidades de forma privada y en local en tu propio ordenador. Luego te hablo un poco más de esto último, pero ahora permíteme que hable un poco sobre cómo está aprovechando Meta su modelo de lenguaje.

LLaMA de Meta está llegando a las aplicaciones más populares

Meta.ai es la plataforma que aprovecha LLaMA para ejecutar tareas. Vale, el modelo es de código abierto, pero las implementaciones que se hagan de él pueden no serlo. Por eso, la división de inteligencia artificial de Meta está trabajando para integrar cada vez más funciones de IA en WhatsApp.

Meta quiere que LLaMA sea la base de las funciones de IA en sus plataformas

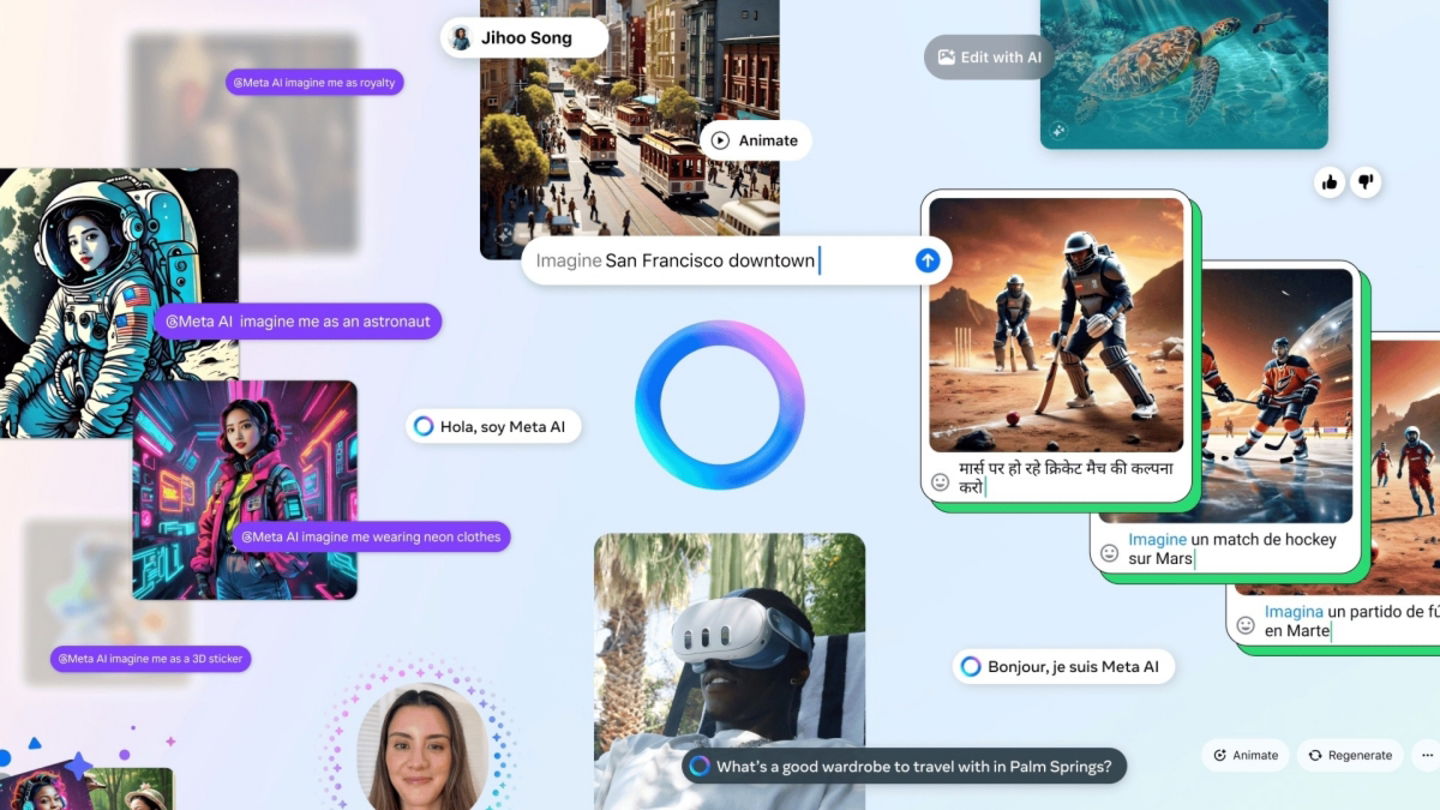

Meta AI es una función de WhatsApp que te permite hablar mediante un chat con un chatbot basado en LLaMA. También es capaz de generar imágenes gracias a modelos específicos. Para llevar a cabo todas estas funciones, solo hay que hablar con la IA desde una conversación o invocar al chatbot con una mención en cualquier chat que mantengas con otras personas.

El punto está en que Meta quiere que LLaMA se integre perfectamente en sus aplicaciones actuales, como WhatsApp, pero tambien en Facebook, Instagram y los dispositivos Quest. Es un modelo de IA para dominarlos a todos. Pero Meta va a ser un desarrollador más que usa LLaMA, porque cualquiera va a poder hacer sus propias implementaciones.

Cómo probar LLaMA de Meta ahora mismo

Si quieres probar LLaMA, dispones de varias opciones. Aquí van algunas de las plataformas donde está disponible este modelo y desde las cuales vas a poder interactuar con él, generalmente, en forma de chatbot.

Meta AI

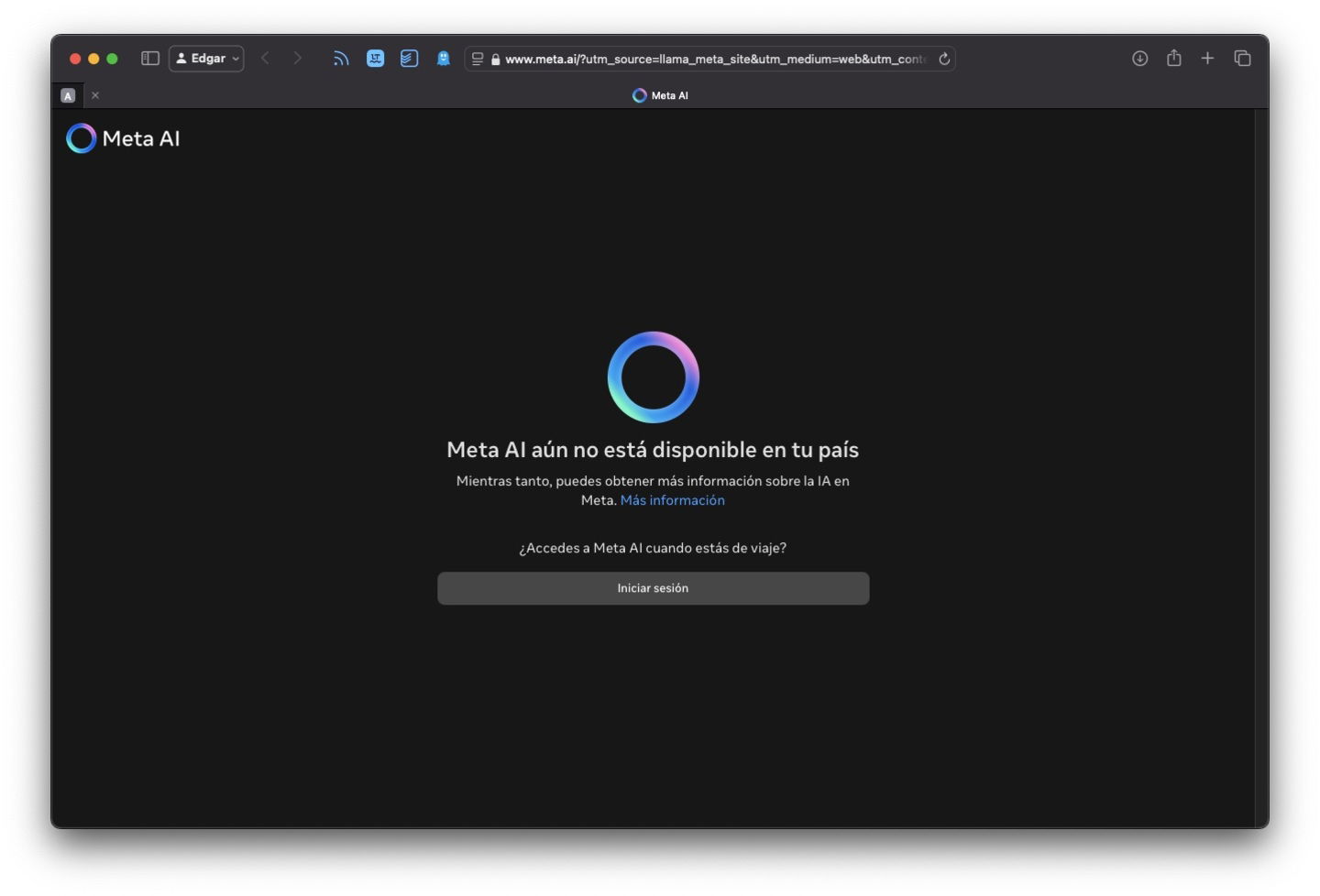

No se puede probar LLaMA desde Meta.ai en España porque, probablemente, no cumple con la regulación europea

Si visitas la página oficial de LLaMA, verás que la opción oficial para probar este modelo es hacerlo desde la plataforma Meta AI. Lo que pasa es que, como se aprecia en la imagen superior, esta opción, en países como España, no está habilitada. Afortunadamente, hay alternativas que te permiten acceder a los modelos de IA de Meta de forma totalmente gratuita y sin restricciones geográficas. Con todo, al tratarse del método oficial y, teniendo en cuenta que sí que está disponible en otras regiones, como en los países de Latinoamérica, tocaba incluirlo en este listado.

HuggingChat

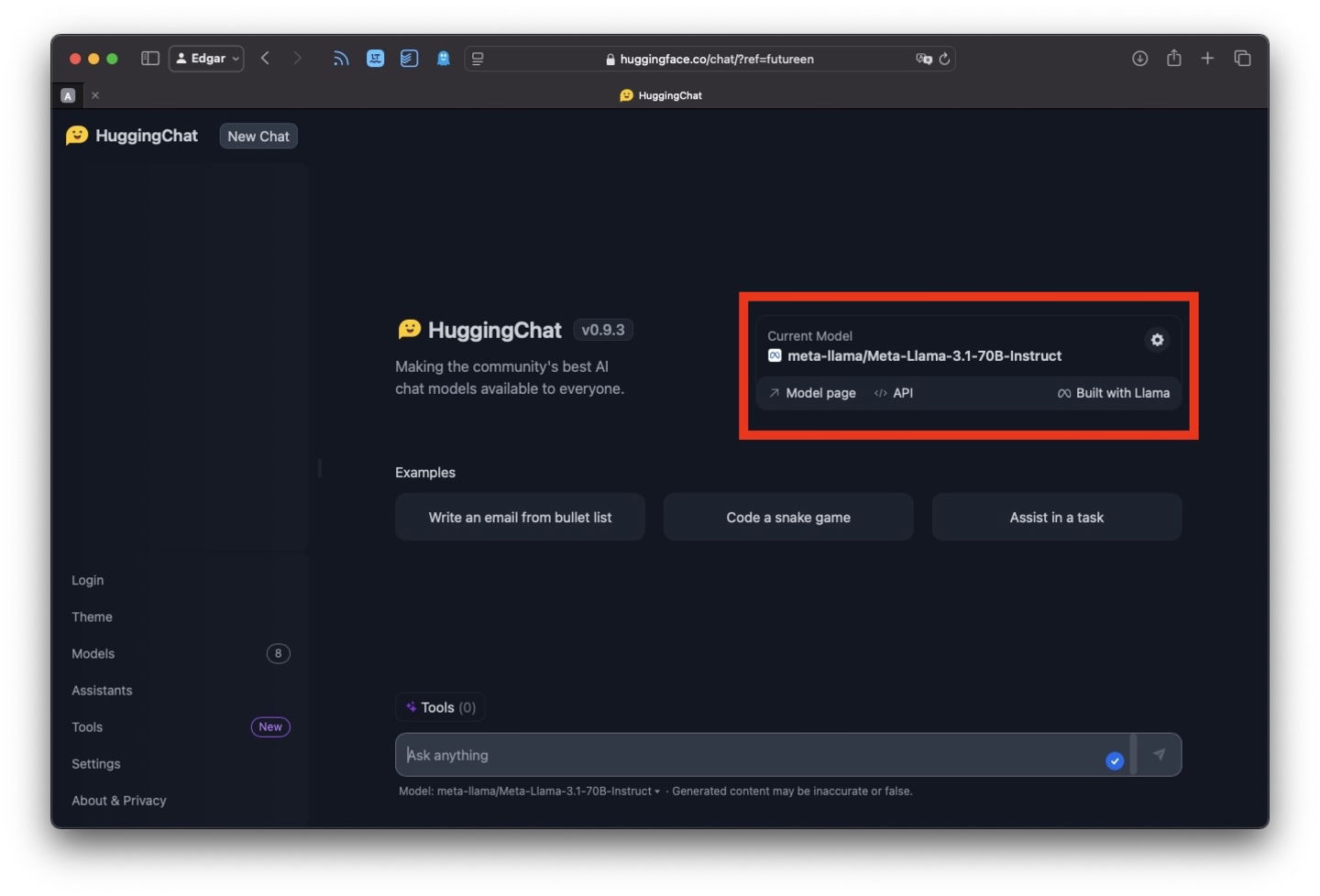

Con HuggingFace vas a poder probar distintos modelos, entre ellos los últimos de Meta

HuggingChat es una herramienta que debes seguir muy de cerca si quieres estar al día de todo lo que tiene que ver con la inteligencia artificial y los nuevos modelos que salen al mercado. Si accedes a este chatbot verás que es posible seleccionar el modelo que deseas emplear para obtener respuestas. En función del modelo que elijas, vas a tener unas opciones u otras. Por ejemplo, si habilitas LLaMA 3.2 11B, dispondrás de búsqueda en la web (la búsqueda se efectúa con Google). Si seleccionas el modelo LLaMA 3.1, dispondrás de algunas herramientas adicionales, como la generación de imagen. En cualquier caso, este chat es un lugar con el cual jugar con distintos modelos y exprimirlos al máximo.

Duck.ai

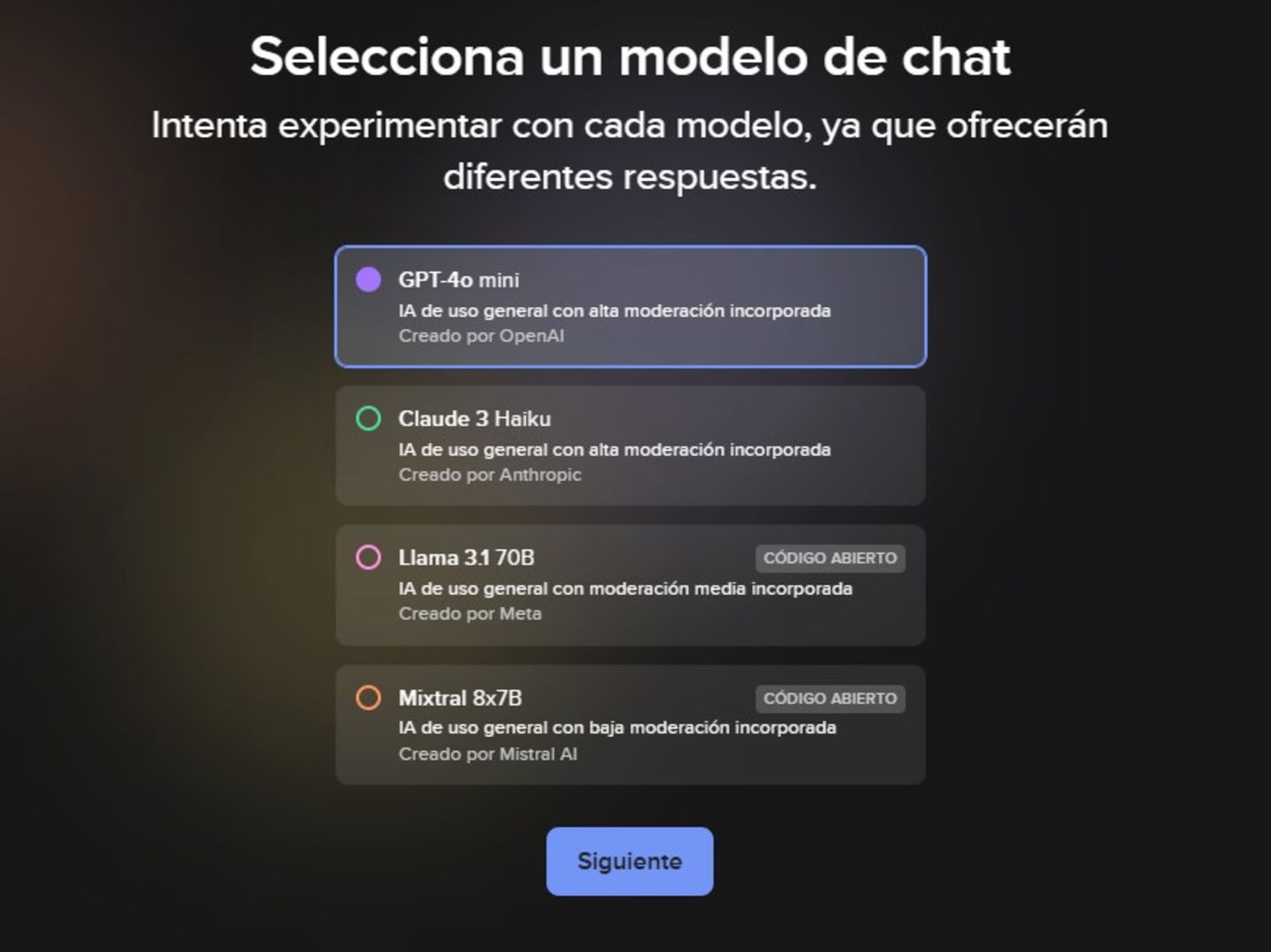

Duck AI es otra forma de usar modelos de lenguaje de manera privada, incluyendo los de Meta

Duck.ai es otro chatbot donde está disponible LLaMA. En el momento de escribir estas líneas, se podía probar LlaMA 3.1 70B. Cuando accedas al chatbot de DuckDuckGo por primera vez, vas a poder seleccionar el modelo que prefieras. No es necesario que te ciñas a LLaMA, sino que también tienes disponibles modelos de Open AI o Mistral. Desde la misma interfaz, vas a poder probar las capacidades de cada uno, incluso enviándoles la misma petición a cada uno y explorando las respuestas para ver cuál es más completa o se adapta mejor a tu petición.

Ollama

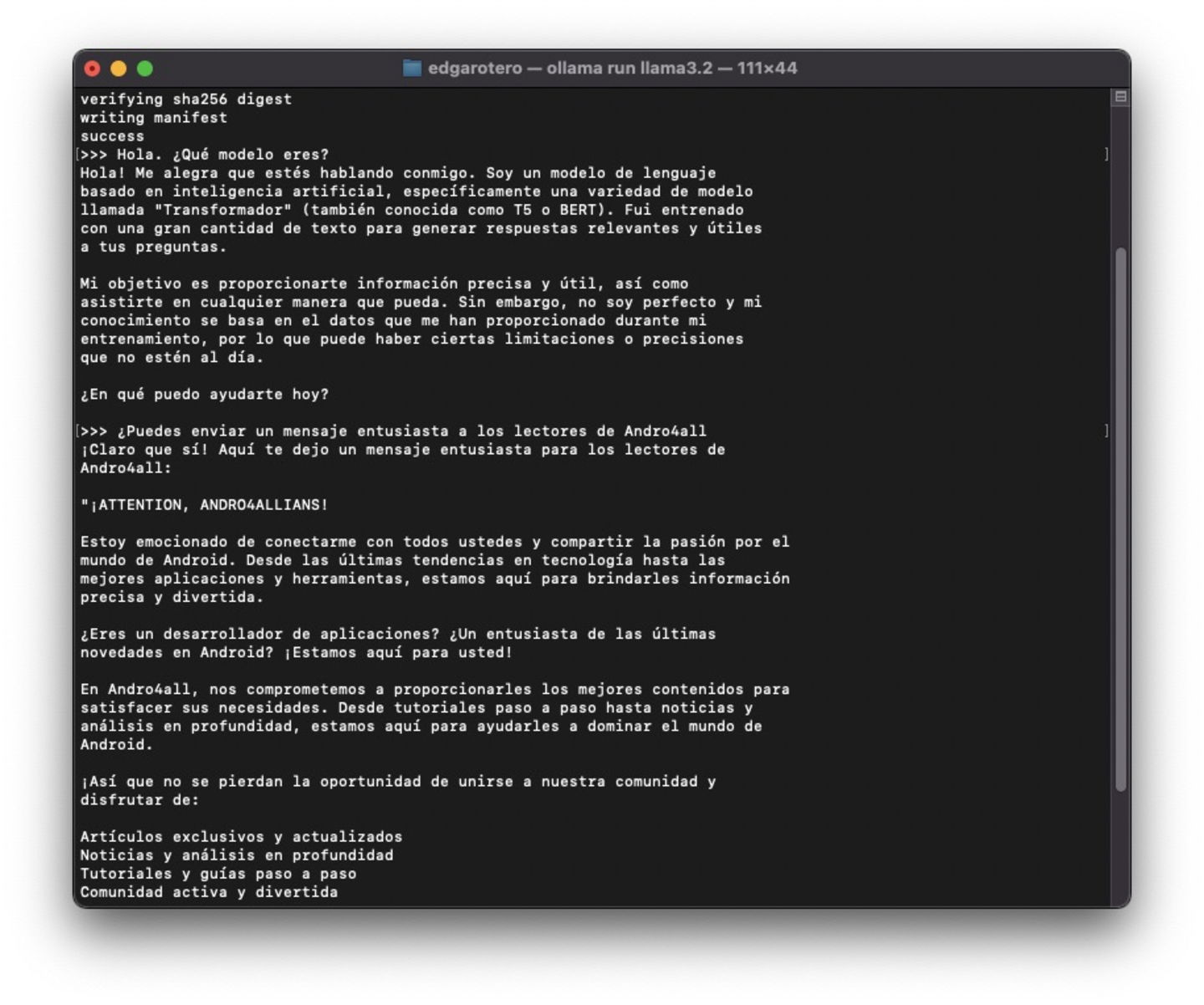

Ollama permite acceder a LLaMA desde la consola del sistema

Todas las opciones anteriores ejecutan LLaMA en la nube. Sin embargo, Ollama te propone algo diferente. Aprovechando la potencia de la tarjeta gráfica de tu ordenador, va a ser capaz de ejecutar LLaMA de forma local en tu PC o Mac. Además, a pesar de su nombre, te interesa saber que es compatible con otros modelos, como Gemma 2 de Google o Mistral. Algo interesante es que, al menos en macOS y Linux, toda la interacción se produce a través de la línea de comandos. Puedes descargar Ollama desde su página web oficial y probar distintos modelos. No te preocupes mucho por las especificaciones de tu ordenador. Yo lo he probado en MacBook Air M2 con tan solo 8 GB de RAM y ha funcionado a la perfección.

El artículo Qué es LLaMA, cómo funciona y cómo se puede probar gratis fue publicado originalmente en Andro4all.