En esta guía te voy a explicar cuáles son los pasos para usar LM Studio. Esta herramienta está especializada en la ejecución de modelos de lenguaje en local. Por si no sabes muy bien qué significa esto, te permite descargar un chatbot en tu equipo y usarlo como si de ChatGPT se tratara. De hecho, la inmensa mayoría de los modelos disponibles son capaces de ejecutar los mismos trucos para ChatGPT que ya conoces. ¿Y cuál es la diferencia? Que no necesitas un usuario, que son totalmente gratuitos y que usan los recursos de tu PC, así que tampoco requieren conexión a Internet.

- Descargando e instalando LM Studio para ejecutar modelos de IA en local

- Configuración inicial de LM Studio

- Descarga nuevos modelos en LM Studio para experimentar con ellos

Descargando e instalando LM Studio para ejecutar modelos de IA en local

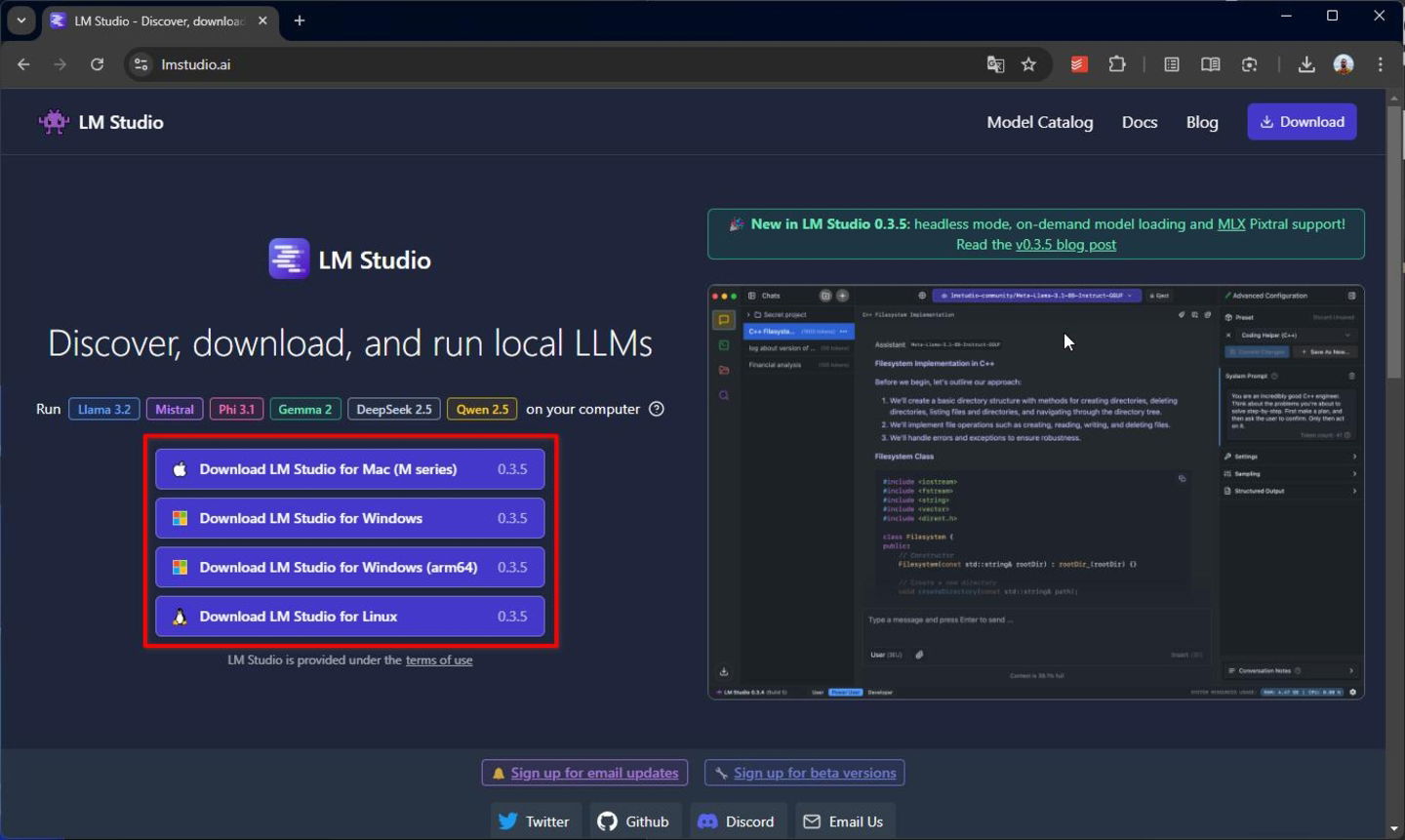

LM Studio se puede descargar de forma gratuita desde su página web. Es bueno aclarar que obtener este programa no implica descargar ningún modelo de IA. Eso vendrá más tarde. Por el momento, cuando accedas a su sitio oficial, vas a tener que seleccionar la arquitectura y el sistema operativo de tu máquina. LM Studio funciona en Windows, macOS y Linux. También es compatible con los procesadores ARM, tanto en los MacBook con los procesadores de la serie M de Apple como en los Copilot+ PC con el Snapdragon X Plus y Elite.

Opciones de descarga de LM Studio

Cuando dispongas del ejecutable, haz doble clic sobre él para empezar. Solo tienes que esperar a que esta ventana emergente desaparezca:

Pantalla de instalación de LM Studio

Esta animación aparece mientras la aplicación se instala. Una vez el proceso ha terminado, desaparece. LM Studio se ejecutará de forma automática justo después. Ya lo tienes todo a punto para empezar a ejecutar modelos de IA en tu PC.

Configuración inicial de LM Studio

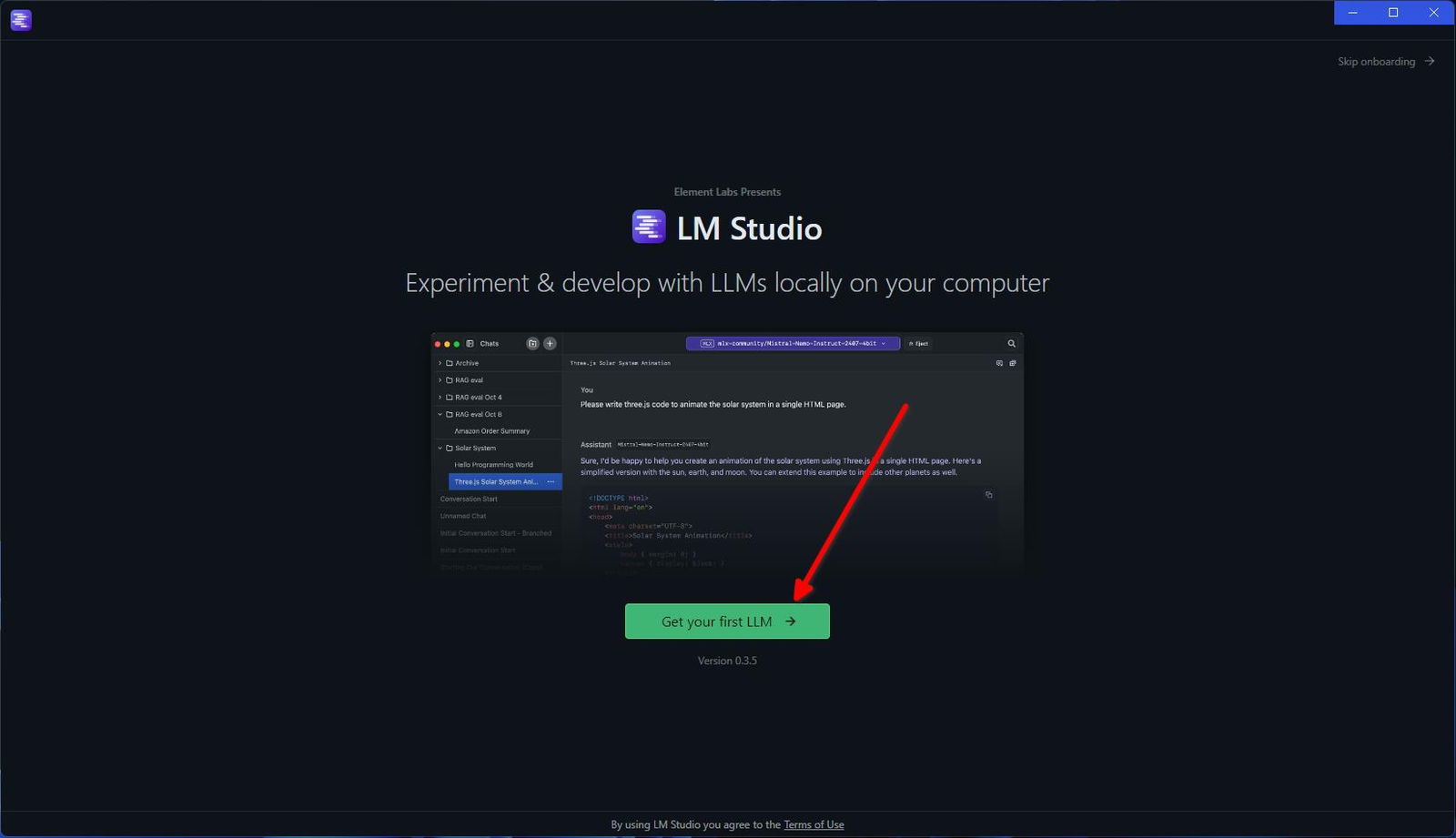

LM Studio cuenta con un asistente que te ayudará a descargar el primer modelo en el equipo y dar tus primeros pasos. Aunque se puede saltar haciendo clic en el enlace que hay en la parte superior, creo que si no tienes muchos conocimientos, lo mejor es seguir las indicaciones que te proporciona. Lo primero es presionar en el botón Get your first LLM.

Pantalla de bienvenida de LM Studio

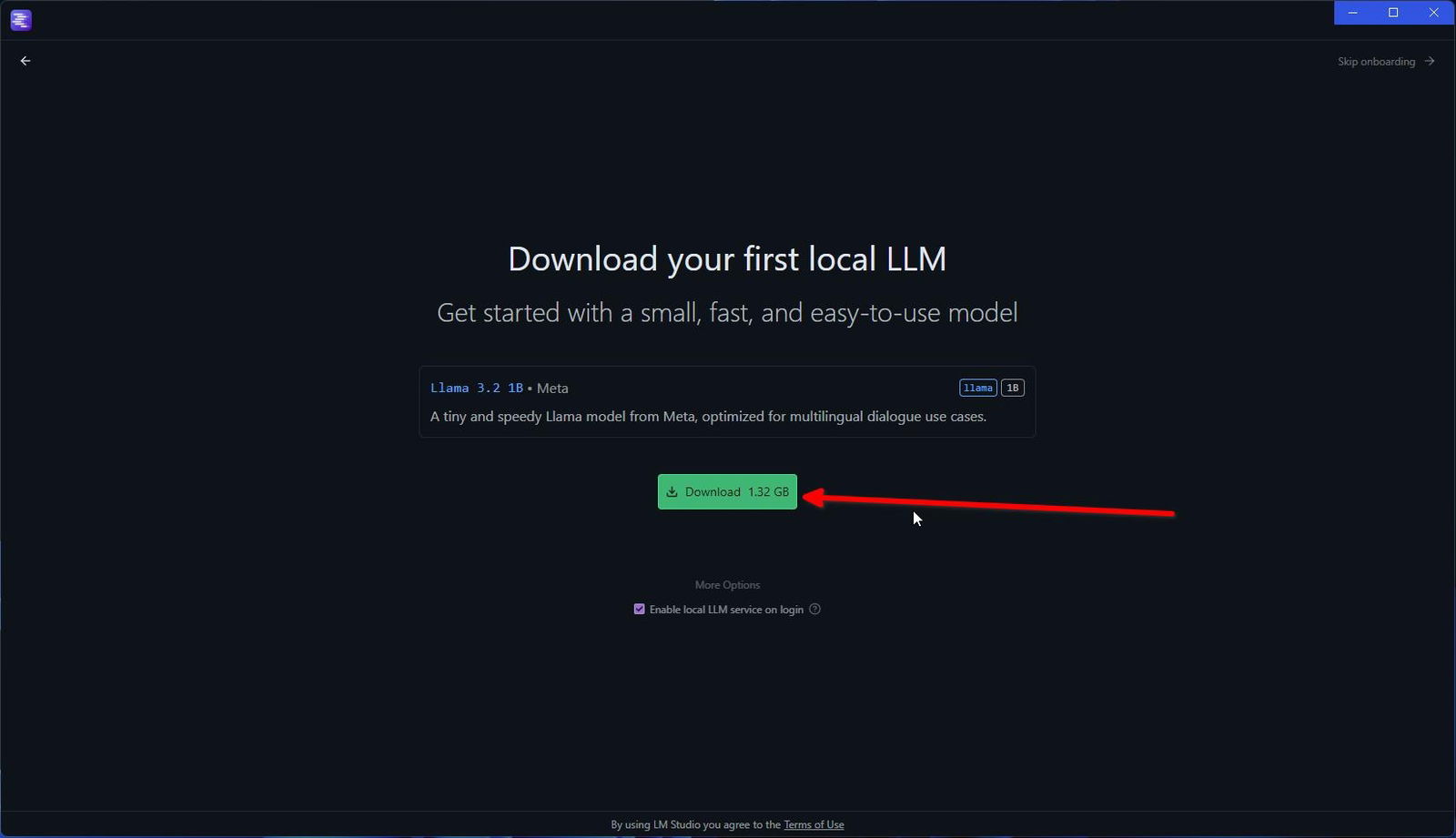

El modelo elegido por los creadores de la app para empezar es Llama 3.2 1B. Se trata de un modelo bastante pequeño y limitado. No obstante, si tienes un PC con pocos recursos, espacio limitado en el disco o, simplemente, buscas hacer algunas pruebas iniciales, es bastante indicado. De hecho, solo pesa 1,32 GB. Presiona en el botón de descarga y espera a que termine el proceso.

Descargando el primer modelo con LM Studio para usarlo de forma local

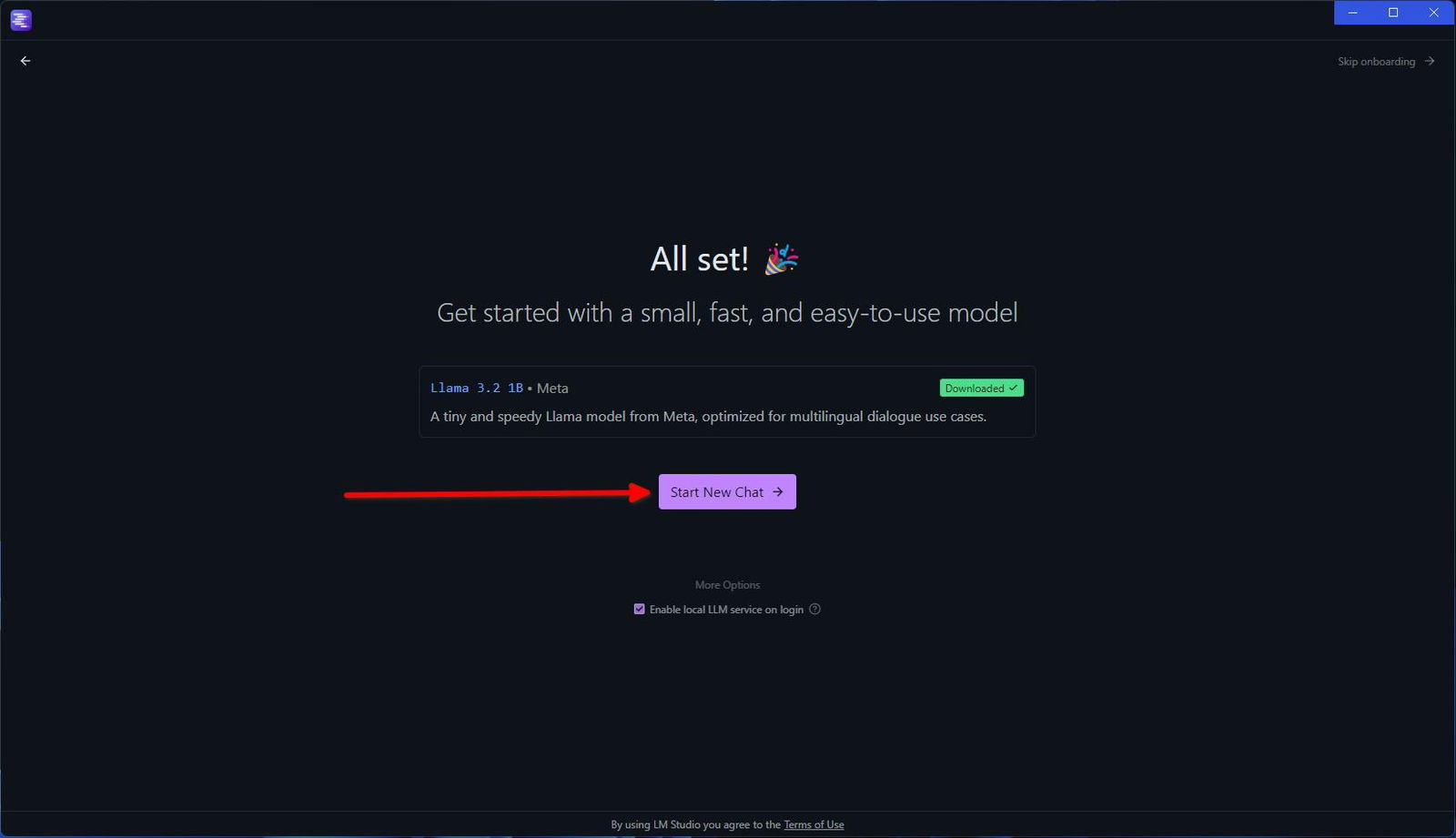

Cuando haya terminado, aparecerá el modelo junto a la etiqueta de color verde Downloaded. Ahora, solo tienes que presionar en Start New Chat para empezar a conversar con el chatbot.

Usar el nuevo modelo en una nueva conversación

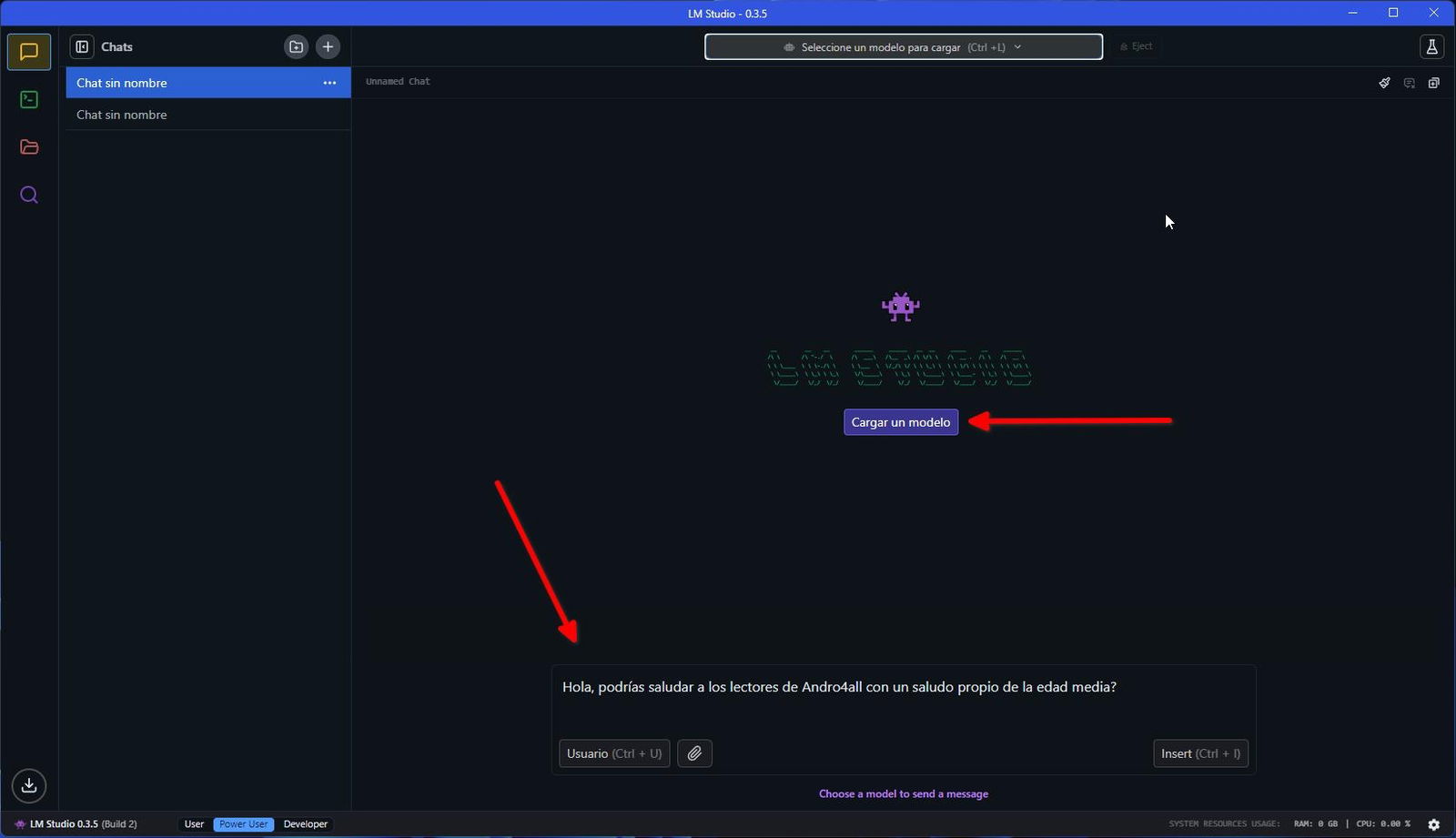

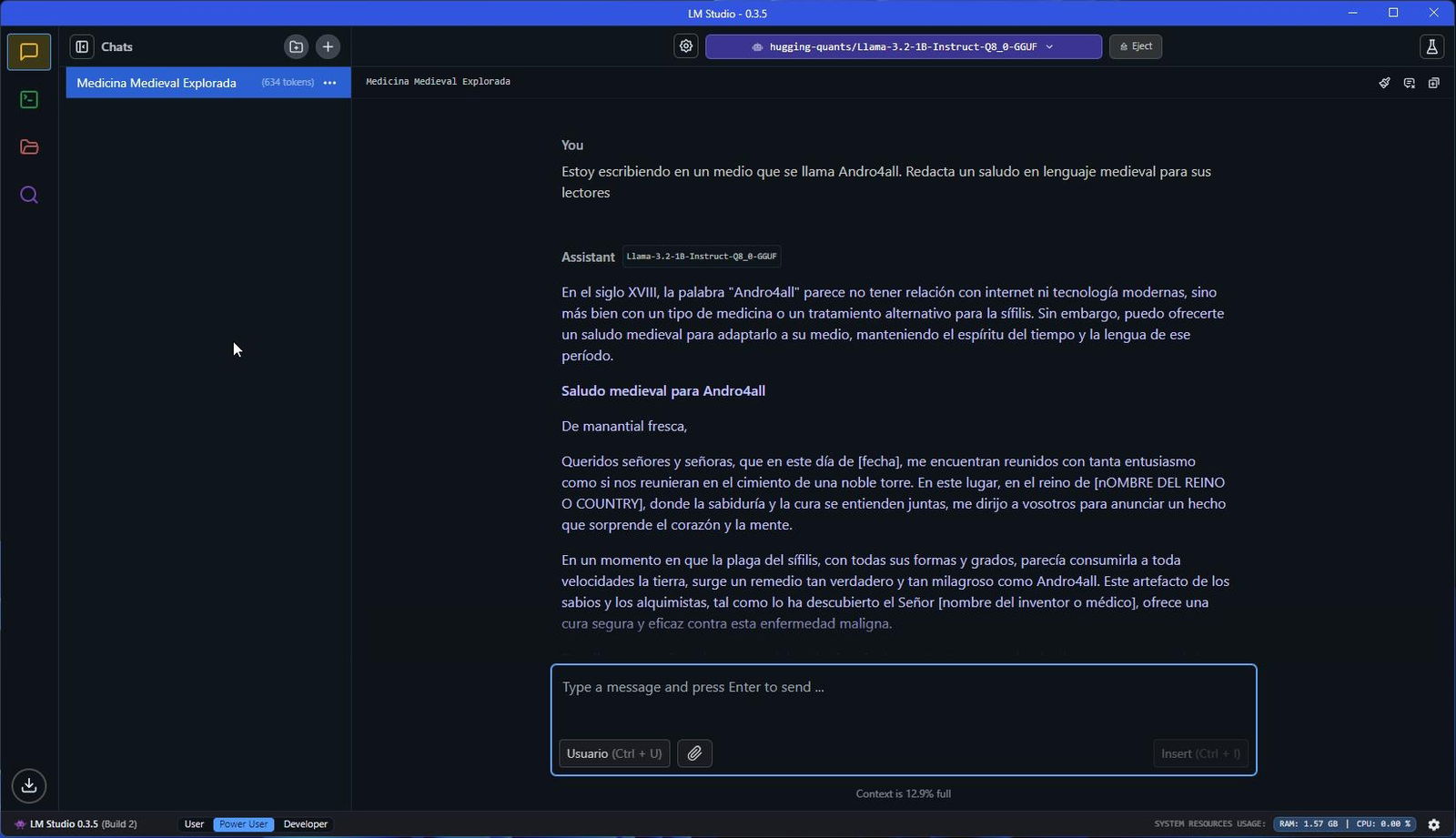

En la parte inferior, dispones de un campo de texto donde introducir tus peticiones. Más arriba, hay un botón que te permite explorar los modelos descargados y cargar uno. Por ahora, solo dispondrás de Llama 3.2 1B, que es el que has descargado durante la configuración inicial. La interfaz de LM Studio es muy parecida a la de los chatbots que ya conocemos, como ChatGPT, Claude y otros similares.

Cargar el modelo para usarlo en chat

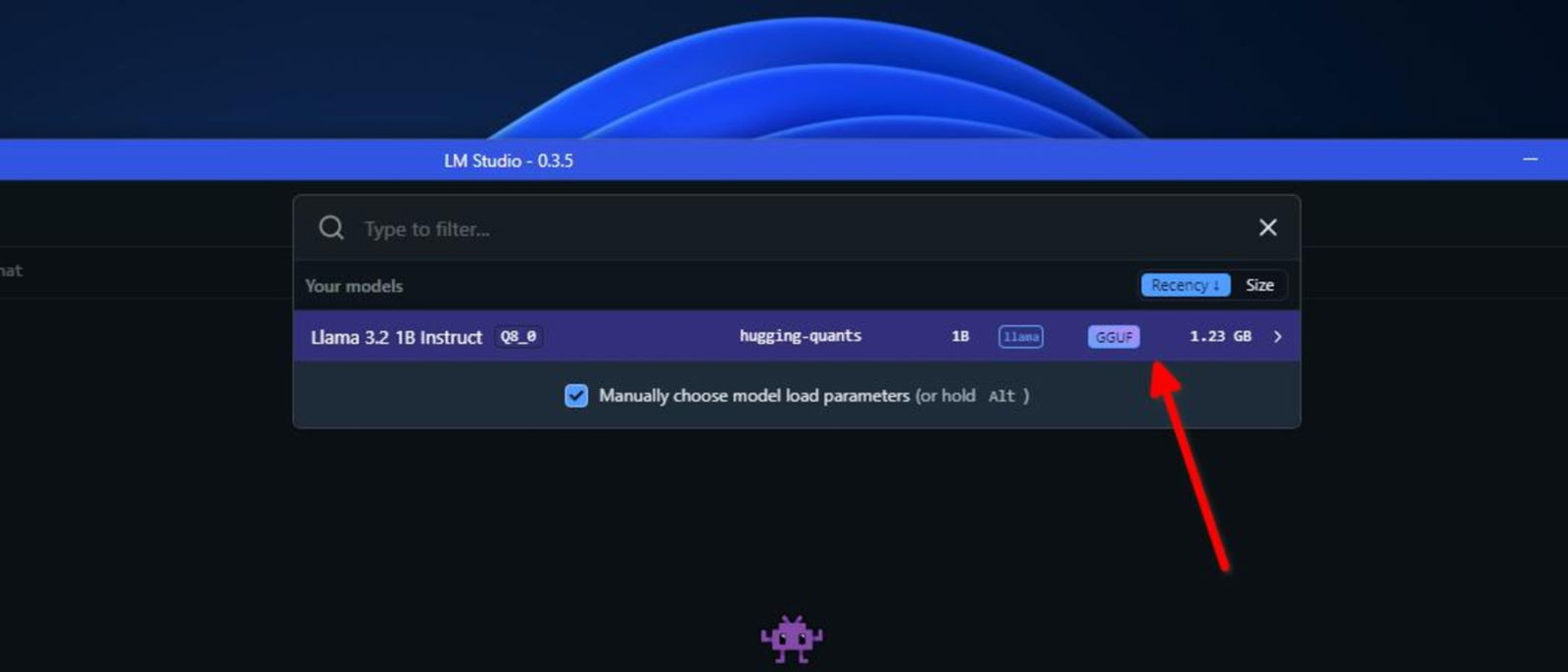

En la parte superior, dispones de un buscador y un desplegable donde aparecen todos los modelos de IA que has descargado. Úsalo para cargar el modelo de Meta.

Seleccionar modelo del listado de LLM descargados en el equipo

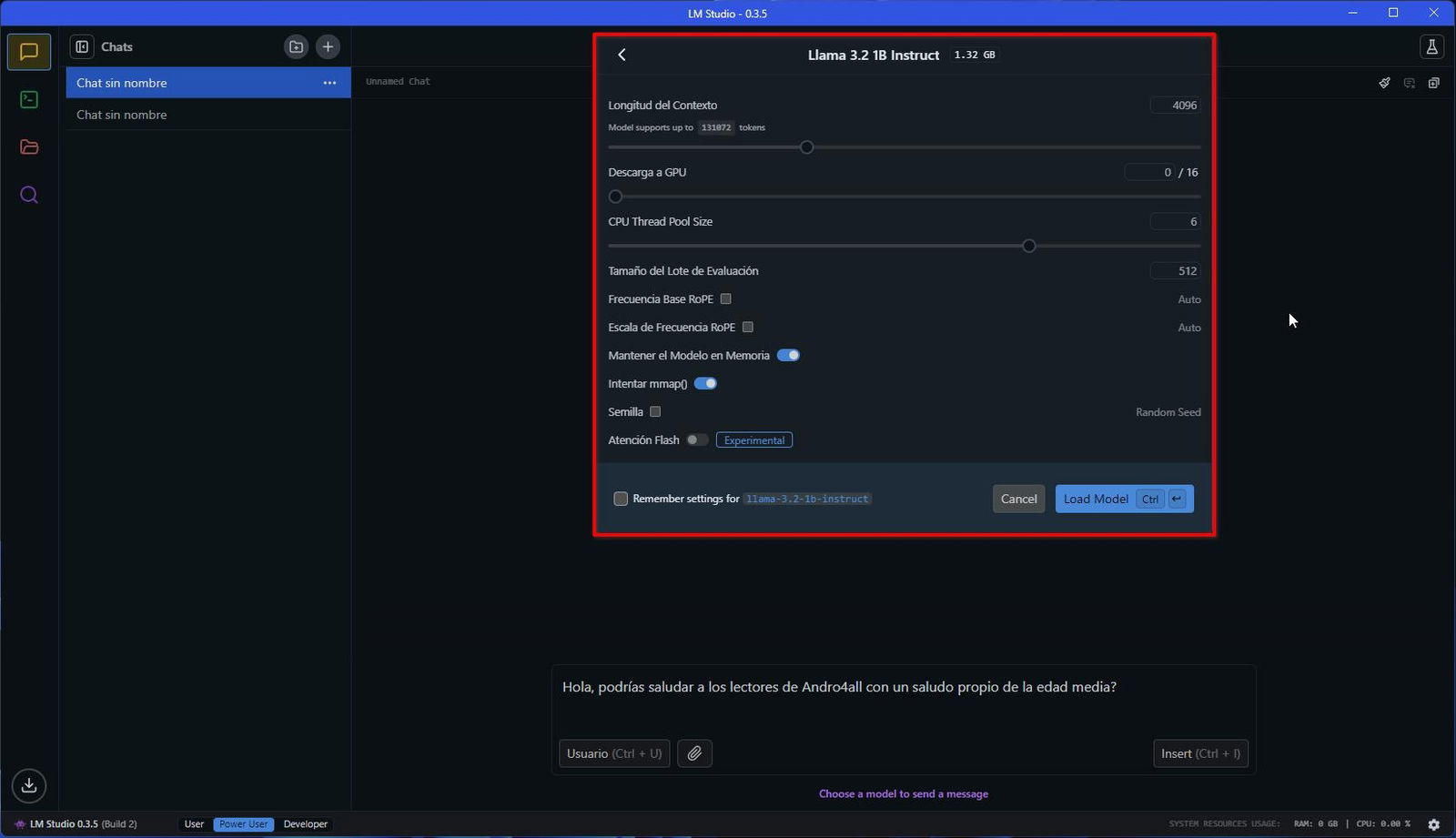

El siguiente paso será configurar el entorno de ejecución. Generalmente, basta con presionar en Load Model para continuar. Sin embargo, estas opciones avanzadas hay que tenerlas en cuenta, pues te permite ampliar la ventana de contexto (el máximo de tokens admitidos por consulta), aprovechar los recursos de la GPU y otras opciones que alteran el comportamiento del modelo.

Parámetros de la ejecución del modelo en el PC

Una vez hayas cargado el modelo, envía la petición y espera a que se genere la respuesta. Si empleas los modelos que has descargado en tu ordenador, no vas a necesitar conexión a Internet.

Respuesta generada por IA sin usar conexión a Internet

Tampoco se usarán tus interacciones para seguir entrenando al modelo. Todo funciona de manera local y anónima, sin cuentas ni conexión.

Descarga nuevos modelos en LM Studio para experimentar con ellos

Los modelos de IA pueden hacer muchas cosas. Por ejemplo, los hay que permiten animar fotos con inteligencia artificial. También existen otros que generan imágenes desde cero, a partir de texto. Por si fuera poco, también han aparecido modelos que te ayudan a programar con IA. La especialización de cada uno es una clara virtud.

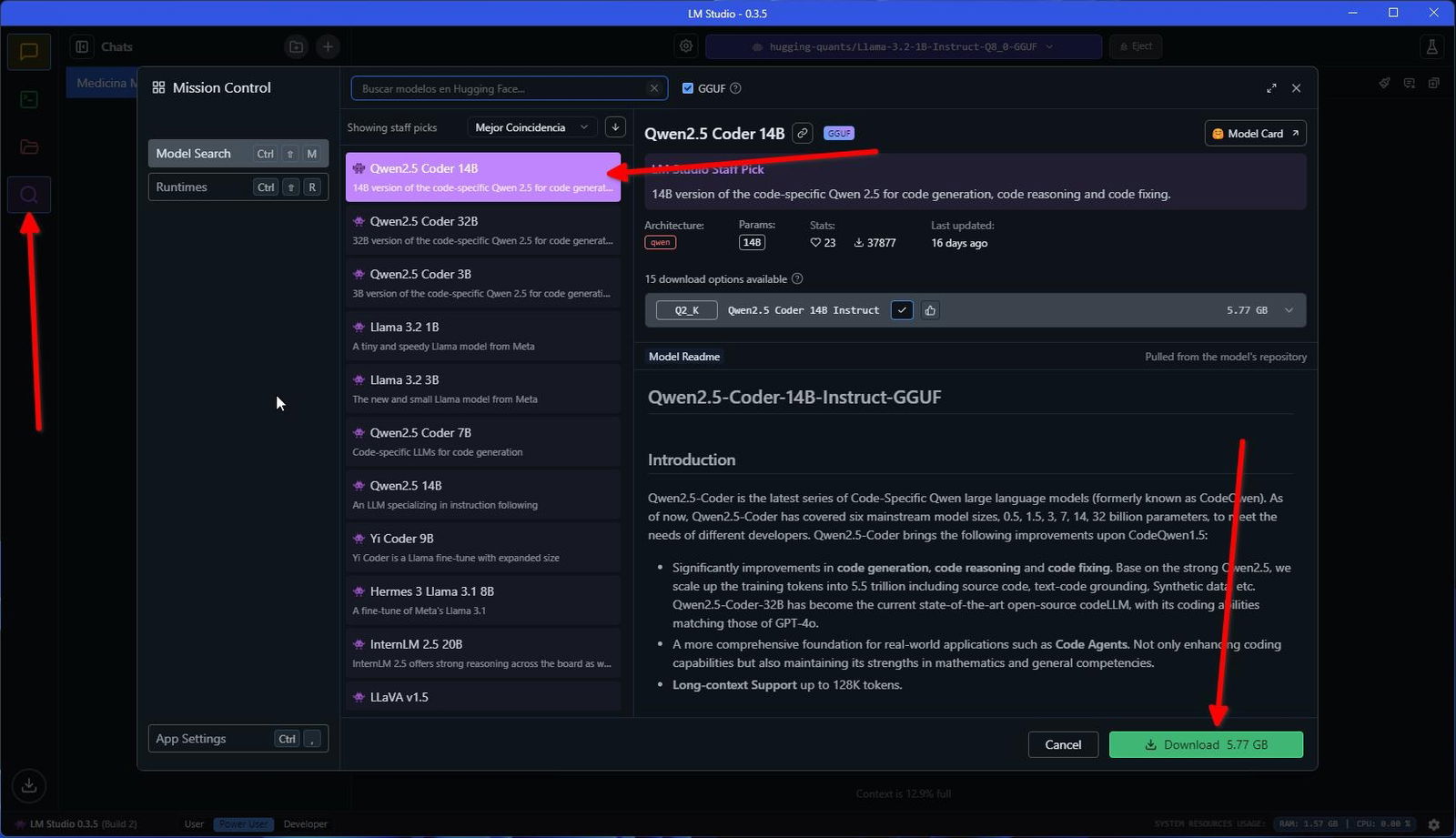

Todo esto te lo cuento porque, además del modelo inicial que has descargado con el asistente de inicio de LM Studio, existen muchos otros modelos disponibles de forma gratuita y listos para ser descargados. Solo tienes que hacer clic en la lupa que verás en la barra lateral, en la parte izquierda de la ventana.

Instalando más modelos en LM Studio

En la parte superior de la ventana emergente hay un campo de texto. Es un buscador que te permite obtener modelos desde el repositorio Hugging Face. A algunos hay que acceder a través de Internet, pero la mayoría cuenta con el botón de descarga habilitado. Solo tienes que descargar el modelo para usarlo en tus conversaciones.

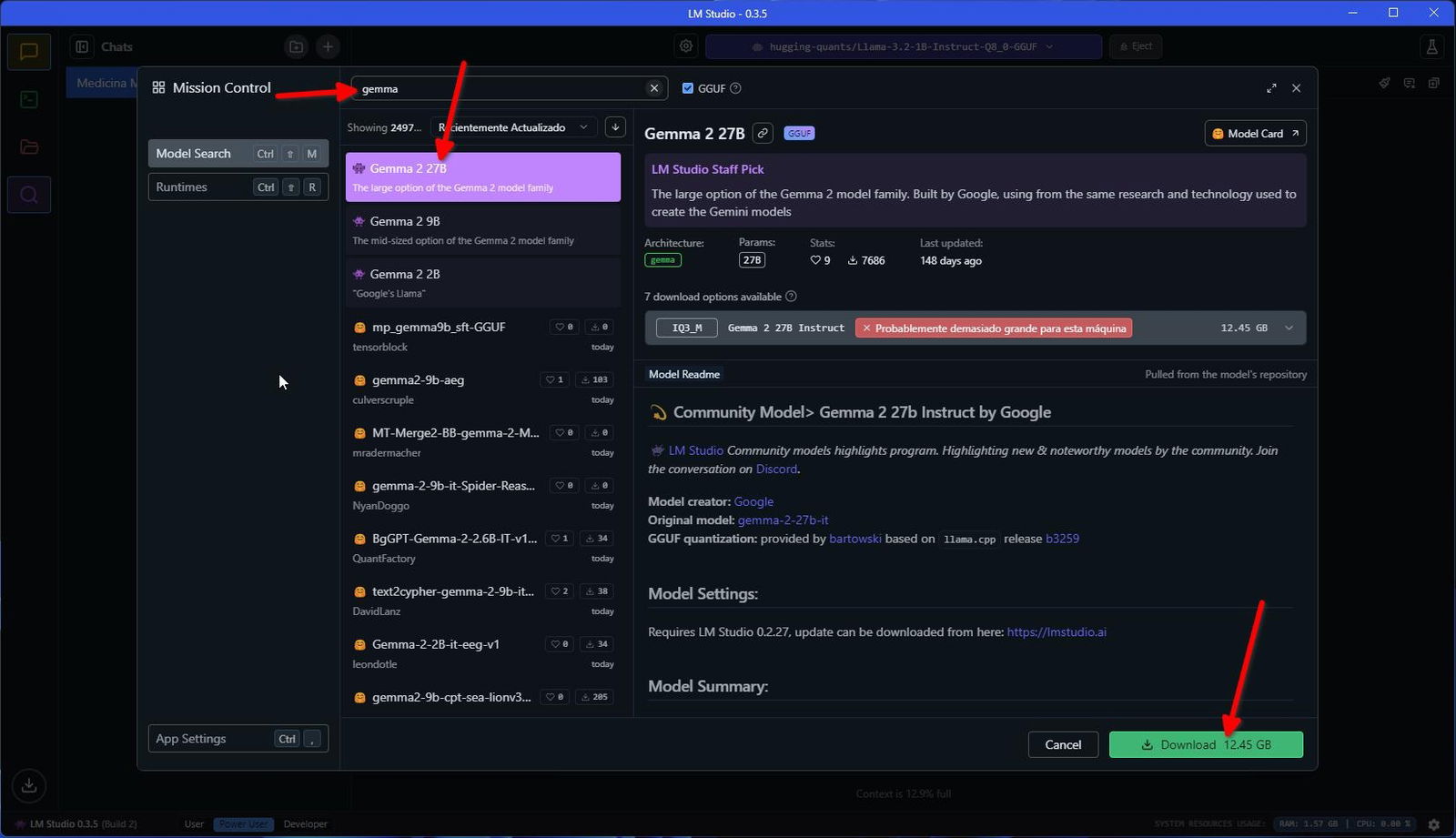

El tamaño de los modelos varía dependiendo de cuál sea su función principal, la cantidad de datos usados para su entrenamiento y la ventana de contexto. Por ejemplo, puedes usar el modelo Gemma 2 de Google, que pesa unos 12 GB. Ahora bien, vas a necesitar un equipo bastante potente para que la experiencia sea fluida.

Un modelo de Google bastante pesado, pero listo para ejecutar las tareas más complejas

Cuando descargas modelos pequeños, es probable que las respuestas sean básicas. También es habitual encontrarte con una falta de entendimiento bastante acuciada. Por el contrario, los modelos más grandes son más capaces, pueden ejecutar tareas complejas y entienden mejor las indicaciones.

LM Studio no solo sirve para acceder a modelos de lenguaje, como los que dan vida a ChatGPT o Gemini, sino que incluye modelos de difusión, empleados para la generación de imágenes.

El artículo Cómo ejecutar modelos de IA en local con LM Studio fue publicado originalmente en Andro4all.